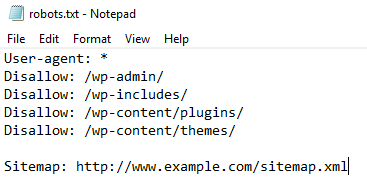

SEO adalah salah satu aspek terpenting dalam membangun kehadiran digital yang kuat. Dalam dunia yang semakin kompetitif, para praktisi SEO harus selalu mengikuti perubahan dan tren terbaru agar website mereka tetap muncul di hasil pencarian Google. Salah satu elemen penting dalam teknis SEO adalah file robots.txt. File ini berfungsi sebagai panduan bagi mesin pencari seperti Googlebot untuk menentukan halaman mana yang boleh mereka rayapi dan mana yang tidak.

Dalam artikel ini, kita akan membahas bagaimana penggunaan file robots.txt dapat memengaruhi kinerja SEO dan mengapa penting untuk mengelolanya dengan benar. Terlebih lagi, ada beberapa prinsip dasar yang perlu dipahami oleh setiap praktisi SEO agar tidak membuat kesalahan yang bisa merugikan peringkat website.

Praktik Ini Merupakan Ide Buruk

John Mueller, seorang ahli teknis dari Google, pernah menyampaikan bahwa melakukan update robots.txt berkali-kali dalam sehari adalah ide yang buruk. Menurutnya, Google melakukan caching pada file robots.txt hingga 24 jam. Oleh karena itu, jika Anda mengubah file tersebut secara berulang dalam waktu singkat, Googlebot mungkin tidak akan mendeteksi perubahan tersebut secara efisien.

Mueller juga memberi saran bahwa jika terjadi crawl berlebihan, lebih baik menggunakan respons HTTP seperti 503 atau 429 daripada melakukan pembaruan yang berlebihan. Hal ini dilakukan untuk menghindari gangguan pada proses crawling dan indexing website.

Menurut dokumentasi resmi Google Search Central, file robots.txt memiliki cache yang bisa bertahan lama, sehingga perubahan yang dilakukan secara terus-menerus tidak akan langsung terlihat oleh mesin pencari. Ini bisa menyebabkan masalah dalam indeksasi halaman penting, terutama jika terdapat kesalahan konfigurasi.

Kapan Waktu Terbaik untuk Melakukan Update pada Robots.txt?

Jika Anda ingin melakukan update pada file robots.txt, pilihlah waktu ketika traffic website sedang rendah. Hal ini akan meminimalkan dampak negatif terhadap user experience dan proses crawling. Selain itu, waktu yang tepat untuk melakukan update adalah ketika Anda menyadari adanya kesalahan pada konfigurasi yang menyebabkan Googlebot tidak dapat merayapi halaman penting.

Tidak semua halaman website perlu dirayapi oleh Googlebot. Misalnya, halaman login atau thank you page biasanya tidak perlu ditampilkan di hasil pencarian. Oleh karena itu, penting untuk menentukan dengan jelas mana halaman yang perlu diindeks dan mana yang tidak.

Ayo Setting Robots.txt dengan Benar!

File robots.txt sebaiknya disetting dengan benar dan tidak sering diubah. Kesalahan dalam pengaturan file ini bisa menyebabkan masalah teknis SEO yang cukup serius. Contohnya, jika Anda secara tidak sengaja melarang Googlebot mengakses halaman konten utama, maka halaman tersebut tidak akan muncul di hasil pencarian, yang tentu saja merugikan visibilitas website.

Untuk memastikan bahwa file robots.txt bekerja dengan baik, Anda bisa menggunakan tools seperti Google Search Console untuk memeriksa apakah file tersebut diakses dan diterapkan dengan benar. Selain itu, pastikan bahwa file robots.txt tidak terlalu dinamis, karena ini bisa memicu masalah dalam crawling dan indexing.

Pentingnya Memahami Teknis SEO

Sebagai praktisi SEO, memahami teknis-teknis dasar seperti robots.txt sangat penting. Banyak kesalahan teknis yang terjadi karena kurangnya pemahaman tentang cara kerja mesin pencari. Misalnya, kesalahan dalam pengaturan canonical tag atau noindex tag bisa menyebabkan duplikasi konten atau penurunan peringkat.

Selain itu, teknik SEO juga melibatkan penggunaan structured data, optimasi kecepatan website (seperti PageSpeed Insights), dan pengelolaan link internal dan eksternal. Semua elemen ini saling terkait dan perlu dikelola dengan baik agar website bisa mencapai peringkat yang optimal di Google.

Tips untuk Mengelola Robots.txt

- Hindari Perubahan Berlebihan: Jangan melakukan update robots.txt terlalu sering. Tunggu sampai traffic website turun sebelum melakukan perubahan.

- Periksa Konfigurasi: Pastikan file robots.txt tidak melarang Googlebot mengakses halaman penting.

- Gunakan Tools Analisis: Gunakan Google Search Console untuk memantau apakah file robots.txt bekerja dengan baik.

- Konsisten dalam Pengelolaan: Jangan membuat file robots.txt terlalu dinamis, karena ini bisa menyebabkan masalah dalam crawling.

Dengan memahami dan mengelola file robots.txt dengan benar, Anda bisa memastikan bahwa Googlebot dapat merayapi halaman website Anda secara efisien. Ini akan berdampak positif pada indeksasi dan peringkat website di hasil pencarian Google.

Referensi Tambahan

- How Google interprets the robots.txt specification

- Google: Don’t Make A Dynamically Generated robots.txt

- Google: Don’t Dynamically Update Robots.txt File Multiple Times Per Day

Jika Anda ingin belajar lebih lanjut tentang teknik SEO, Anda bisa bergabung dengan kursus SEO Fundamental di DailySEO ID. Materi akan dibawakan langsung oleh Muhammad Ilman Akbar, founder DailySEO ID.