Google baru saja merilis panduan terbaru mengenai robots.txt, yang menjadi salah satu elemen penting dalam optimasi teknis website. Dokumen ini dirancang untuk membantu para praktisi SEO dan webmaster memahami cara mengontrol perayapan mesin pencari seperti Google, Bing, dan lainnya melalui aturan sederhana di file teks tersebut. Dengan pemahaman yang lebih baik tentang fungsi dan penggunaan robots.txt, Anda bisa meningkatkan efisiensi crawling dan indexing website Anda.

Panduan baru ini memberikan penjelasan lengkap tentang apa itu robots.txt, bagaimana ia bekerja, serta bagaimana menggunakannya untuk membatasi akses ke halaman tertentu atau mengelola perilaku crawler. Selain itu, dokumen ini juga mencakup contoh-contoh penggunaan yang bisa diterapkan oleh para pengelola website, termasuk pemblokiran halaman seperti shopping cart, pengaturan khusus untuk bot tertentu, hingga penggunaan komentar untuk dokumentasi internal. Ini menjadikannya sebagai referensi yang sangat berguna bagi siapa pun yang ingin memahami cara mengoptimalkan struktur website secara teknis.

Dalam konteks SEO, penggunaan robots.txt yang tepat bisa sangat berpengaruh pada kinerja website. Jika tidak dikelola dengan baik, file ini bisa menyebabkan masalah seperti crawl budget yang tidak optimal, atau bahkan mencegah mesin pencari mengindeks halaman penting. Oleh karena itu, pemahaman mendalam tentang dokumentasi terbaru dari Google ini sangat penting bagi setiap praktisi SEO.

Apa Itu Robots.txt?

Robots.txt adalah file teks yang ditempatkan di akar domain sebuah website (misalnya https://www.contohwebsite.com/robots.txt). File ini digunakan untuk memberi instruksi kepada crawler mesin pencari seperti Googlebot, Bingbot, dan lainnya tentang halaman mana yang boleh mereka kunjungi dan mana yang tidak. Dengan demikian, Anda bisa mengontrol bagaimana mesin pencari mengekspor isi website Anda.

Fungsi utama dari robots.txt adalah:

- Mencegah crawler mengunjungi halaman yang tidak ingin Anda indeks.

- Menghindari penggunaan crawl budget untuk halaman yang tidak relevan.

- Menjaga privasi data sensitif atau konten yang belum selesai.

Namun, penting untuk dicatat bahwa robots.txt bukan alat untuk melindungi konten dari akses publik. Meskipun file ini bisa mencegah crawler, konten yang tersedia di luar jangkauan robots.txt tetap bisa diakses oleh siapa saja jika tidak dilindungi dengan metode lain seperti password atau HTTPS.

Perubahan Terbaru dalam Panduan Robots.txt

Dokumen terbaru dari Google mencakup beberapa penambahan dan penjelasan yang lebih jelas dibandingkan versi sebelumnya. Salah satu hal yang menonjol adalah penekanan pada fakta bahwa robots.txt adalah protokol web yang telah stabil selama 30 tahun dan didukung oleh banyak mesin pencari. Hal ini menunjukkan bahwa meskipun ada evolusi dalam teknologi SEO, prinsip dasar dari robots.txt tetap relevan.

Selain itu, panduan ini menjelaskan bahwa jika file robots.txt tidak ditemukan, Google Search Console (GSC) akan menampilkan pesan kesalahan 404. Namun, ini bukanlah masalah serius, karena GSC akan menghilangkan pesan tersebut setelah 30 hari. Jika Anda masih merasa tidak nyaman, Anda bisa membuat file robots.txt kosong yang tetap dapat dipahami oleh Google.

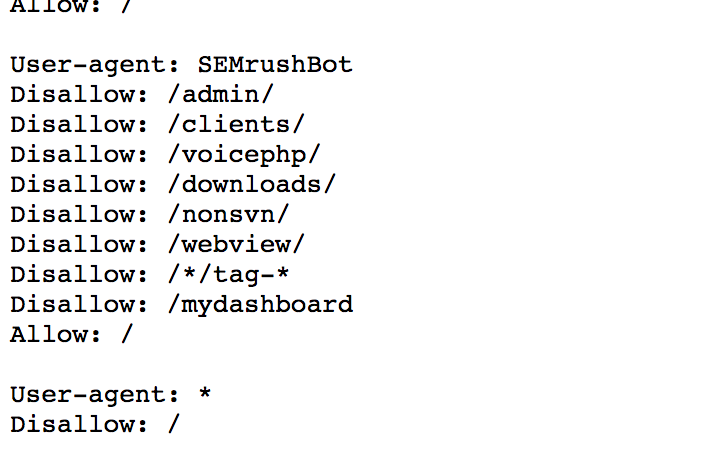

Penggunaan Advanced Robots.txt

Panduan ini juga membahas penggunaan lanjutan dari robots.txt, termasuk:

- Membatasi crawler tertentu: Anda bisa menulis aturan yang berbeda untuk bot berbeda, seperti Googlebot dan Bingbot.

- Memblokir pola URL: Contohnya, Anda bisa memblokir semua file PDF atau halaman pencarian (

search). - Kontrol detail terhadap bot: Misalnya, Anda bisa membatasi jumlah waktu yang dihabiskan oleh bot di situs Anda.

- Menambahkan komentar: Ini berguna untuk dokumentasi internal dan memudahkan tim SEO dalam memahami aturan yang ditetapkan.

Dengan fitur-fitur ini, praktisi SEO bisa lebih fleksibel dalam mengelola akses ke berbagai bagian website, terutama untuk situs besar dengan ribuan halaman.

Cara Membuat dan Mengedit Robots.txt

Membuat dan mengedit file robots.txt cukup sederhana. Anda hanya perlu menggunakan editor teks seperti Notepad, Sublime Text, atau Visual Studio Code. Berikut langkah-langkahnya:

- Buka editor teks.

- Tulis aturan sesuai kebutuhan. Contoh:

User-agent: *

Disallow: /admin/

Disallow: /shopping-cart/ - Simpan file dengan nama

robots.txt. - Unggah file tersebut ke folder root domain Anda (misalnya

https://www.contohwebsite.com/robots.txt).

Jika Anda menggunakan CMS seperti WordPress, Anda bisa mengedit file robots.txt langsung melalui panel admin atau plugin SEO. Beberapa alat juga tersedia untuk menguji apakah file robots.txt Anda sudah benar, seperti Google Search Console atau Robots.txt Checker.

Tips untuk Praktisi SEO

Bagi praktisi SEO, berikut beberapa tips yang bisa Anda terapkan:

- Pastikan file robots.txt tidak menghalangi crawler dari mengakses konten penting.

- Hindari pemblokiran halaman yang seharusnya diindeks, seperti halaman produk atau artikel.

- Gunakan tools seperti Screaming Frog untuk memeriksa file robots.txt secara otomatis.

- Lakukan audit berkala untuk memastikan file ini tetap sesuai dengan kebutuhan website.

Dengan penerapan yang tepat, file robots.txt bisa menjadi alat yang sangat berguna dalam optimasi teknis website dan meningkatkan kinerja SEO secara keseluruhan.

Kesimpulan

Panduan terbaru Google tentang robots.txt menawarkan wawasan yang lebih mendalam tentang cara mengelola akses crawler ke website Anda. Dengan memahami dan menerapkan aturan yang tepat, Anda bisa meningkatkan efisiensi crawling dan indexing, sehingga memperbaiki visibilitas website di hasil pencarian. Untuk informasi lebih lanjut, Anda bisa mengunjungi Google’s official documentation.